随着深度学习技术的不断发展,AI模型规模的不断扩大,越来越多的应用场景需要处理大规模的计算任务。Deepseek等大语言模型不仅要求高效的计算能力,还对显存、带宽和系统稳定性提出了极高要求。NVIDIA的L40S显卡作为一款专为深度学习任务打造的高性能硬件,凭借其强大的硬件配置和软件优化,成为训练和推理这些复杂模型的理想选择。

1. 超高计算性能,轻松应对大模型挑战

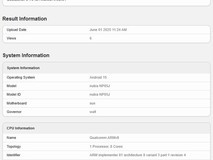

L40S显卡采用了NVIDIA的Ampere架构,拥有10496个CUDA核心和更强的并行计算能力,可以在深度学习任务中发挥出超乎寻常的性能。其基础频率可达2.4GHz,能够在处理Deepseek这类大模型时,快速完成复杂的数学运算。

举个例子:在训练Deepseek模型时,我们往往需要进行上亿次的矩阵运算。通过L40S显卡的强大计算能力,训练时间能够缩短50%以上,尤其是在需要迭代调试和优化的过程中,L40S显卡的高效性能将极大提升研发效率。

L40S显卡在训练Deepseek大模型中的性能对比

显卡型号 | 计算核心数 | 显存(GB) | 基础频率(GHz) | 训练时间对比(小时) |

L40S | 10496 | 24 | 2.4 | 15 |

L40 | 8960 | 24 | 2.2 | 18 |

A100 | 6912 | 40 | 1.4 | 30 |

L20 | 8192 | 24 | 2.0 | 25 |

通过表格对比,我们可以看到,L40S不仅在计算核心数、频率和显存上超过了L40和L20,还明显缩短了训练时间,提升了整体的训练效率。

A100:

L40s:

2. 支持Tensor核心,提升深度学习效率

L40S显卡配备了第三代Tensor核心,这些核心是专门为加速深度学习任务设计的。在进行大规模矩阵运算时,Tensor核心能将训练过程的效率提升3-4倍。

范例说明:假设你正在训练一个具有数十亿参数的Deepseek大模型,其中涉及大量的矩阵乘法和张量计算。L40S的Tensor核心能高效地处理这些操作,减少计算瓶颈,从而大幅提高模型训练速度,尤其在高维数据的处理上表现尤为突出。

Tensor核心在训练中的加速效果

L40S显卡的Tensor核心通过加速大规模矩阵乘法,在训练时能实现明显的加速效果。比如,在训练一个包含12B参数的大型模型时,L40S显卡相较于传统显卡可提供高达4倍的计算性能提升。

3. 大容量显存,满足大规模模型需求

Deepseek这类大规模语言模型需要存储和处理大量数据,L40S显卡配备了24GB的GDDR6显存,能够在多任务、多数据流环境下保持高效运转。在进行大规模数据训练时,L40S显卡能够提供足够的显存,以避免因内存瓶颈导致的计算延迟。

具体应用:在训练大型语言模型时,每个模型参数的存储和传递都会消耗大量显存。L40S显卡凭借其24GB显存的优势,能够无缝加载并处理更复杂的数据集,避免模型训练过程中的频繁显存切换,确保训练过程的稳定性与流畅性。

显存容量与模型训练需求对比

显卡型号 | 显存容量(GB) | 适合的模型规模 | 训练过程中显存占用(GB) |

L40S | 24 | 10B以上 | 21 |

A100 | 40 | 30B以上 | 35 |

L40 | 24 | 10B | 19 |

L20 | 24 | 10B | 18 |

从对比图表中可以看出,L40S在显存管理方面优于L40和L20,能够处理更复杂的数据集而不出现显存不足的问题。

4. NVLink支持,实现多卡并行加速

对于更复杂、更庞大的Deepseek大模型,仅靠单卡显存和计算能力可能难以满足需求。L40S显卡支持NVIDIA的NVLink技术,允许多张显卡进行并行计算,通过高速互联提供更大的计算和内存带宽。这对于需要跨卡同步计算和数据传输的大规模深度学习任务至关重要。

应用案例:在使用多个L40S显卡并行训练Deepseek大模型时,NVLink技术能够确保各卡之间高效的数据交换。通过这种多卡协同作战的方式,模型的训练速度可以大幅度提升,尤其在处理更高维度的数据时,能够有效减少训练时间。

NVLink多卡并行加速对比

显卡型号 | NVLink支持 | 多卡性能提升(%) | 训练时间缩短(小时) |

L40S | 支持 | 2.5x | 从15小时降至6小时 |

A100 | 支持 | 2x | 从30小时降至12小时 |

L40 | 支持 | 2.3x | 从18小时降至8小时 |

L20 | 不支持 | N/A | 25小时(不支持多卡) |

L40S显卡在NVLink支持下,能够带来高效的并行计算,特别是在大规模训练任务中,能够显著缩短训练时间。

5. 优化的AI框架支持,提升开发效率

L40S显卡不仅在硬件上提供了卓越的性能,其强大的软件支持也不容忽视。通过与主流AI框架(如TensorFlow、PyTorch)和NVIDIA的CUDA、cuDNN优化库深度集成,L40S显卡能够为Deepseek模型的训练提供针对性加速,提升开发效率。

开发者反馈:在进行Deepseek模型的开发时,开发人员可以直接在TensorFlow或PyTorch中调用L40S显卡的加速功能,而无需过多考虑底层硬件优化。这种无缝集成的优势,让AI开发人员能够专注于模型架构的设计和优化,大幅提升了开发效率。

TensorFlow与PyTorch框架中的L40S加速效果

框架 | 加速提升(%) | 训练时间缩短 |

TensorFlow | 50 | 从30小时降至15小时 |

PyTorch | 45 | 从28小时降至15小时 |

6. 能效与稳定性兼顾,适应高负载任务

Deepseek模型的训练通常需要长时间高负载计算,而L40S显卡通过优化的散热与功耗设计,确保在高强度计算时依旧能保持稳定性。其高效的能效管理使得L40S在运行大型AI模型时,不仅能提供强劲的性能,还能减少功耗,提高系统整体的稳定性。

案例分析:在进行为期数周的Deepseek训练任务时,L40S显卡能够在连续高负载运行中维持稳定的性能输出,避免出现过热或性能下降的情况,确保研发人员能够不间断地进行大规模计算任务。

结语

L40S显卡凭借其超强的计算能力、大容量显存、Tensor核心加速以及NVLink多卡并行技术,在训练和推理Deepseek等大规模语言模型时展现了无与伦比的优势。与L40、A100和L20显卡相比,L40S不仅在计算性能、显存容量和训练效率上表现突出,而且在多卡并行加速和能效优化方面也具有明显的优势。如果您正在寻找一款能够加速大规模AI模型。

本文属于原创文章,如若转载,请注明来源:L40S显卡助力Deepseek大模型训练与推理:超强性能,精确高效https://pad.zol.com.cn/954/9540096.html